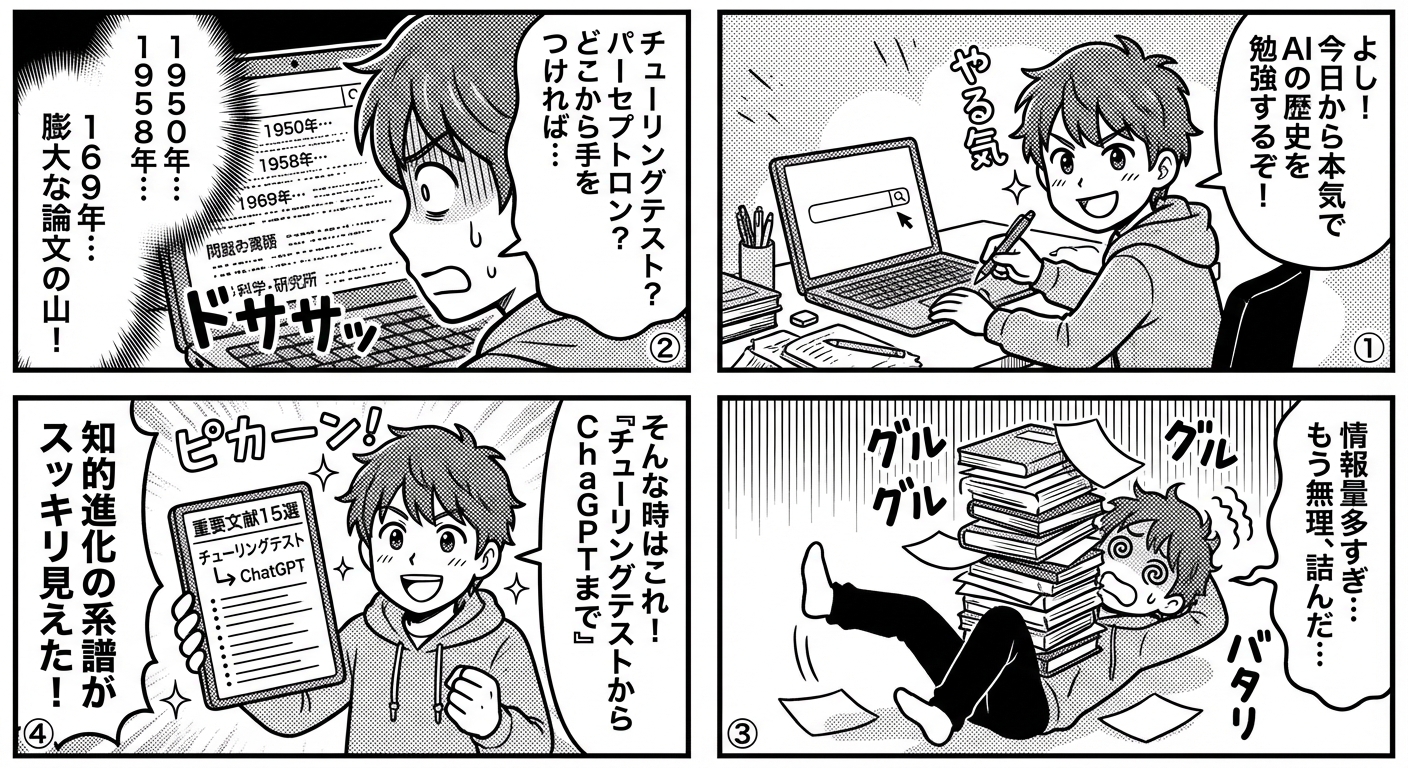

AI研究70年の歴史を変えた重要文献15選──チューリングテストからChatGPTまでの知的進化を辿る

人工知能の発展を理解したいとき、どの論文から読めばよいか迷っていませんか。70年以上にわたるAI研究の歴史には、パラダイムを根本から変えた重要文献が存在します。チューリングテストの提唱から深層学習革命、そして大規模言語モデルの登場まで、各時代を象徴する15の文献を読み解くことで、AI技術の本質的な進化が見えてきます。

この記事では、AI研究の黎明期から現代までを5つの時代に分け、それぞれの時代を代表する重要文献を厳選して紹介します。各文献が提起した問い、もたらした技術革新、そして現代への影響を体系的に解説することで、AI研究の知的系譜を辿ります。

AI研究の基礎を築いた黎明期の文献(1950-1970年代)

人工知能という概念そのものが形成された時期には、今日のAI研究の土台となる根本的な問いが提起されました。この時代の文献は、技術的詳細よりも哲学的・概念的な枠組みを提供した点で重要性を持ちます。

チューリングテストと機械知能の定義

アラン・チューリングが1950年に発表した論文「Computing Machinery and Intelligence」は、「機械は考えることができるか」という問いを、操作可能な実験形式に変換した画期的な文献です。チューリングテストとして知られるこの枠組みは、人間と区別がつかない会話ができれば知能があるとみなすという基準を示しました。

この論文の真の価値は、哲学的議論を実証可能な形に落とし込んだ点にあります。チューリングは「機械は学習できるか」「創造性を持てるか」といった反論を先回りして検討し、AI研究の方向性を定めました。2026年現在、ChatGPTをはじめとする対話AIの評価において、依然としてチューリングテストの概念が参照されています。

パーセプトロンと初期ニューラルネットワーク

フランク・ローゼンブラットが1958年に発表した「The Perceptron: A Probabilistic Model for Information Storage and Organization in the Brain」は、人工ニューラルネットワークの原型を提示しました。単純な二値分類器であるパーセプトロンは、生物学的ニューロンを模倣した計算モデルとして、後の深層学習革命への道を開きました。

しかし、1969年にマービン・ミンスキーとシーモア・パパートが著した「Perceptrons」は、単層パーセプトロンの限界を数学的に証明し、第一次AIブームの終焉を招きました。この批判的文献もまた重要で、XOR問題など線形分離不可能な問題への対処が、後の多層ネットワーク研究を促進したのです。

知識表現とフレーム理論

マービン・ミンスキーの1974年論文「A Framework for Representing Knowledge」は、人間の認知を模倣する知識表現の枠組みを提案しました。フレーム理論は、状況や概念を構造化されたデータとして表現する方法を示し、エキスパートシステムやセマンティックネットワークの基礎となりました。

| 文献 | 著者 | 発表年 | 主要な貢献 |

|---|---|---|---|

| Computing Machinery and Intelligence | アラン・チューリング | 1950 | 機械知能の評価基準(チューリングテスト)の提案 |

| The Perceptron | フランク・ローゼンブラット | 1958 | 人工ニューラルネットワークの原型 |

| Perceptrons | ミンスキー&パパート | 1969 | 単層パーセプトロンの限界の数学的証明 |

| A Framework for Representing Knowledge | マービン・ミンスキー | 1974 | フレーム理論による知識表現 |

これらの黎明期文献は、AI研究の基本的な問いと方法論を確立し、以降の技術発展の礎となりました。次の時代には、これらの理論的基盤の上に実用的なアルゴリズムが構築されていきます。

機械学習の理論的基盤を確立した文献(1980-2000年代)

1980年代から2000年代にかけて、AI研究は理論的成熟期を迎えました。この時期の文献は、現代の機械学習アルゴリズムの数学的基礎を提供し、実用化への道筋をつけました。

バックプロパゲーションと多層ネットワークの復活

デビッド・ルメルハート、ジェフリー・ヒントン、ロナルド・ウィリアムズによる1986年の論文「Learning representations by back-propagating errors」は、誤差逆伝播法(バックプロパゲーション)を体系化し、多層ニューラルネットワークの学習を可能にしました。この手法は、ミンスキーらが指摘した単層パーセプトロンの限界を克服し、ニューラルネットワーク研究を復活させました。

バックプロパゲーションの重要性は、勾配降下法を多層構造に適用する明確な計算手順を示した点にあります。この論文以降、ニューラルネットワークは理論的玩具から実用的ツールへと進化し、現代の深層学習の直接的な先駆けとなりました。

サポートベクターマシンと統計的学習理論

ウラジミール・ヴァプニクとアレクセイ・チェルヴォネンキスが1990年代に発展させたサポートベクターマシン(SVM)は、1995年の論文「Support-Vector Networks」(コルテスとヴァプニク)で集大成を迎えました。SVMはマージン最大化という明確な最適化原理に基づき、高次元空間での分類問題に優れた性能を示しました。

この文献の背景にあるVC次元理論や構造的リスク最小化の概念は、機械学習の理論的基盤を提供しました。2000年代初頭、SVMは画像認識や文書分類で最高性能を達成し、深層学習が台頭するまでの主流技術となりました。

強化学習とQ学習アルゴリズム

クリストファー・ワトキンスの1989年博士論文で提案されたQ学習は、リチャード・サットンとアンドリュー・バートの1998年著書「Reinforcement Learning: An Introduction」で体系化されました。この文献は、環境との相互作用を通じて最適な行動戦略を学習する強化学習の理論的枠組みを確立しました。

Q学習とその発展形である深層Q学習(DQN)は、後にAlphaGoやロボット制御などの画期的成果につながります。報酬信号のみから学習するという強化学習のパラダイムは、教師データが不要な点で他の機械学習手法と一線を画します。

ランダムフォレストとアンサンブル学習

レオ・ブレイマンが2001年に発表した「Random Forests」は、決定木を多数組み合わせるアンサンブル学習の有効性を示しました。ランダムフォレストは、個々の弱学習器を組み合わせて強力な予測モデルを構築するという原理を実証し、実務での機械学習応用を加速させました。

- バックプロパゲーション(1986): 多層ニューラルネットワークの学習を可能にし、深層学習への道を開いた

- サポートベクターマシン(1995): マージン最大化による高精度分類と統計的学習理論の実用化

- 強化学習理論(1998): 環境との相互作用による学習の理論的基盤を確立

- ランダムフォレスト(2001): アンサンブル学習の有効性を実証し、実務応用を促進

この時期の文献群は、現代の機械学習エコシステムの多様性を支える理論的支柱となっています。次の時代には、これらの理論が大規模データと計算資源と結びつき、深層学習革命が起こります。

深層学習革命を牽引した現代の重要文献(2006-2020年代)

2006年以降、ニューラルネットワークは「深層学習」として劇的な復活を遂げました。この時期の文献は、AI技術を研究室から実世界へと押し出し、産業と社会を変革する原動力となりました。

深層信念ネットワークと事前学習

ジェフリー・ヒントンらが2006年に発表した「A Fast Learning Algorithm for Deep Belief Nets」は、深層ニューラルネットワークの効果的な学習方法を示し、深層学習ブームの火付け役となりました。層ごとの事前学習(pre-training)という手法により、それまで困難だった多層ネットワークの訓練が可能になりました。

この論文は、深層学習が「なぜ今うまくいくのか」という問いへの最初の答えを提供しました。事前学習の概念は後に転移学習へと発展し、現代のファインチューニング手法の原型となっています。

畳み込みニューラルネットワークとImageNet革命

アレックス・クリジェフスキー、イリヤ・サツケヴァー、ジェフリー・ヒントンによる2012年の論文「ImageNet Classification with Deep Convolutional Neural Networks」(AlexNet)は、画像認識の精度を劇的に向上させました。ImageNetコンペティションでの圧倒的勝利は、深層学習の実用性を世界に証明した歴史的瞬間でした。

この文献が示したCNN(畳み込みニューラルネットワーク)の有効性は、医療画像診断、自動運転、顔認識など無数の応用を生み出しました。ReLU活性化関数、ドロップアウト、GPUによる並列計算といった技術要素の組み合わせが、現代のコンピュータビジョンの基盤となっています。

系列データ処理とLSTM・Transformer

ユルゲン・シュミットフーバーとセップ・ホッホライターが1997年に提案したLSTM(Long Short-Term Memory)は、2014年頃から自然言語処理で広く採用されました。しかし、真の革命は2017年にアシシュ・ヴァスワニらが発表した「Attention is All You Need」によってもたらされました。

この論文で提案されたTransformerアーキテクチャは、自己注意機構(self-attention)によって系列データの長距離依存関係を効率的に学習する方法を示しました。TransformerはBERT、GPTシリーズ、そして現代の大規模言語モデルすべての基盤技術となり、AI研究史上最も影響力のある文献の一つとなっています。

敵対的生成ネットワークと生成AI

イアン・グッドフェローらが2014年に発表した「Generative Adversarial Networks」(GAN)は、生成モデルの新たなパラダイムを提示しました。生成器と識別器を競わせる枠組みは、リアルな画像・音声・動画の生成を可能にし、創造的AIの基礎を築きました。

GANの登場により、AIは認識・分類だけでなく創造の領域にも進出しました。この概念は後に拡散モデル(Diffusion Models)などへと発展し、2020年代の画像生成AI(Stable Diffusion、DALL-E等)の礎となっています。

| 文献 | 発表年 | 主要技術 | 現代への影響 |

|---|---|---|---|

| Deep Belief Nets | 2006 | 層ごとの事前学習 | 転移学習・ファインチューニングの原型 |

| AlexNet | 2012 | 深層CNN、ReLU、Dropout | コンピュータビジョンの実用化 |

| Attention is All You Need | 2017 | Transformer、自己注意機構 | 大規模言語モデルの基盤技術 |

| Generative Adversarial Networks | 2014 | 敵対的学習 | 画像生成AI、クリエイティブAI |

これらの文献は、深層学習を単なる研究テーマから、産業と社会を変革する技術へと昇華させました。次のセクションでは、これらの成果が結実した大規模言語モデル時代の文献を見ていきます。

大規模言語モデル時代を切り拓いた最新文献(2018-2026年)

2018年以降、AI研究は大規模言語モデル(LLM)を中心に急速に進化しています。この時代の文献は、AIの能力を人間レベルに近づけ、汎用的な知能への道筋を示しつつあります。

BERTと双方向文脈理解

ジェイコブ・デブリンらがGoogleで開発し2018年に発表した「BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding」は、双方向のTransformerを用いた事前学習モデルを提案しました。BERTは文脈の前後両方から単語の意味を理解する能力を獲得し、自然言語処理の多くのタスクで最高性能を達成しました。

BERTの重要性は、大規模な教師なしデータでの事前学習と、少量のタスク固有データでのファインチューニングという二段階学習パラダイムを確立した点にあります。このアプローチは現代のLLM開発の標準的手法となっています。

GPTシリーズと自己回帰型言語モデル

OpenAIが開発したGPTシリーズは、自己回帰型言語モデルの可能性を段階的に拡大してきました。2020年の「Language Models are Few-Shot Learners」(GPT-3論文)は、1750億パラメータのモデルが少数の例示だけで多様なタスクを実行できることを示しました。

この文献は「スケーリング則」の重要性を実証しました。モデルサイズとデータ量を増やすほど性能が向上するという発見は、AI研究の方向性を決定づけました。2022年のChatGPTリリースは、この研究の延長線上にあり、対話型AIを一般に普及させる転換点となりました。

人間のフィードバックによる強化学習(RLHF)

OpenAIの2022年論文「Training language models to follow instructions with human feedback」は、人間の好みを反映させる強化学習手法(RLHF)を体系化しました。この技術により、LLMは単に流暢な文章を生成するだけでなく、有用で安全な応答を生成できるようになりました。

RLHFはChatGPTやClaude、Geminiなど主要な対話AIの核心技術です。人間の価値観をAIに組み込むアライメント問題への実践的アプローチとして、2026年現在も活発に研究されています。

マルチモーダルAIと統合的知能

2021年のOpenAI論文「Learning Transferable Visual Models From Natural Language Supervision」(CLIP)は、画像とテキストを共通の埋め込み空間で学習する手法を提案しました。このマルチモーダルアプローチは、異なる種類のデータを統合的に理解するAIへの道を開きました。

CLIPの概念は、GPT-4やGemini 1.5のようなマルチモーダルLLMへと発展しています。視覚、言語、音声を統合的に処理する能力は、より人間に近い汎用的知能の実現に不可欠な要素となっています。

- BERT(2018): 双方向事前学習による文脈理解の革新

- GPT-3(2020): スケーリング則とfew-shot学習の実証

- RLHF論文(2022): 人間の好みを反映するアライメント技術

- CLIP(2021): マルチモーダル学習による統合的知能

これらの最新文献は、AIを専門家のツールから誰もが使える技術へと民主化し、社会のあらゆる領域に影響を与えています。最終セクションでは、これら15の文献が示す知的進化の全体像をまとめます。

まとめ──70年の知的進化が示す未来への示唆

本記事では、AI研究70年の歴史を形作った15の重要文献を時代順に辿ってきました。チューリングの根源的な問いから始まり、パーセプトロンによる計算モデルの誕生、バックプロパゲーションによる多層学習の実現、ImageNetでの深層学習の実証、Transformerによる系列処理の革新、そしてChatGPTに代表される大規模言語モデルの普及まで、各文献は時代のパラダイムシフトを象徴しています。

これらの文献に共通するのは、既存の限界を打破する新しい視点や手法を提示し、後続研究の方向性を決定づけた点です。チューリングテストは評価基準を、バックプロパゲーションは学習アルゴリズムを、Transformerはアーキテクチャを、RLHFはアライメント手法を確立しました。それぞれの文献は、技術的詳細だけでなく概念的枠組みを提供することで、AI研究コミュニティ全体の進路を形成してきました。

2026年現在、AI技術は多くの領域で人間の能力に迫り、一部では凌駕しています。しかし、真の汎用人工知能(AGI)への道のりはまだ長く、因果推論、常識的理解、効率的な学習など多くの課題が残されています。今後の重要文献は、これらのフロンティアを切り拓くものになるでしょう。

AI研究の歴史を学ぶことは、単なる知識の蓄積ではありません。先人たちがどのように困難な問題に取り組み、創造的な解決策を見出してきたかを知ることで、あなた自身が未来のAI技術を形作る洞察を得られるはずです。これらの文献が示す知的勇気と探究心を胸に、あなたもAI研究の次章を書く一員となってください。技術の進化は終わることなく、あなたの貢献を待っています。