AI×心理学研究の最前線:人間の心を解き明かす機械学習モデルと倫理的課題【2026年最新論文レビュー】

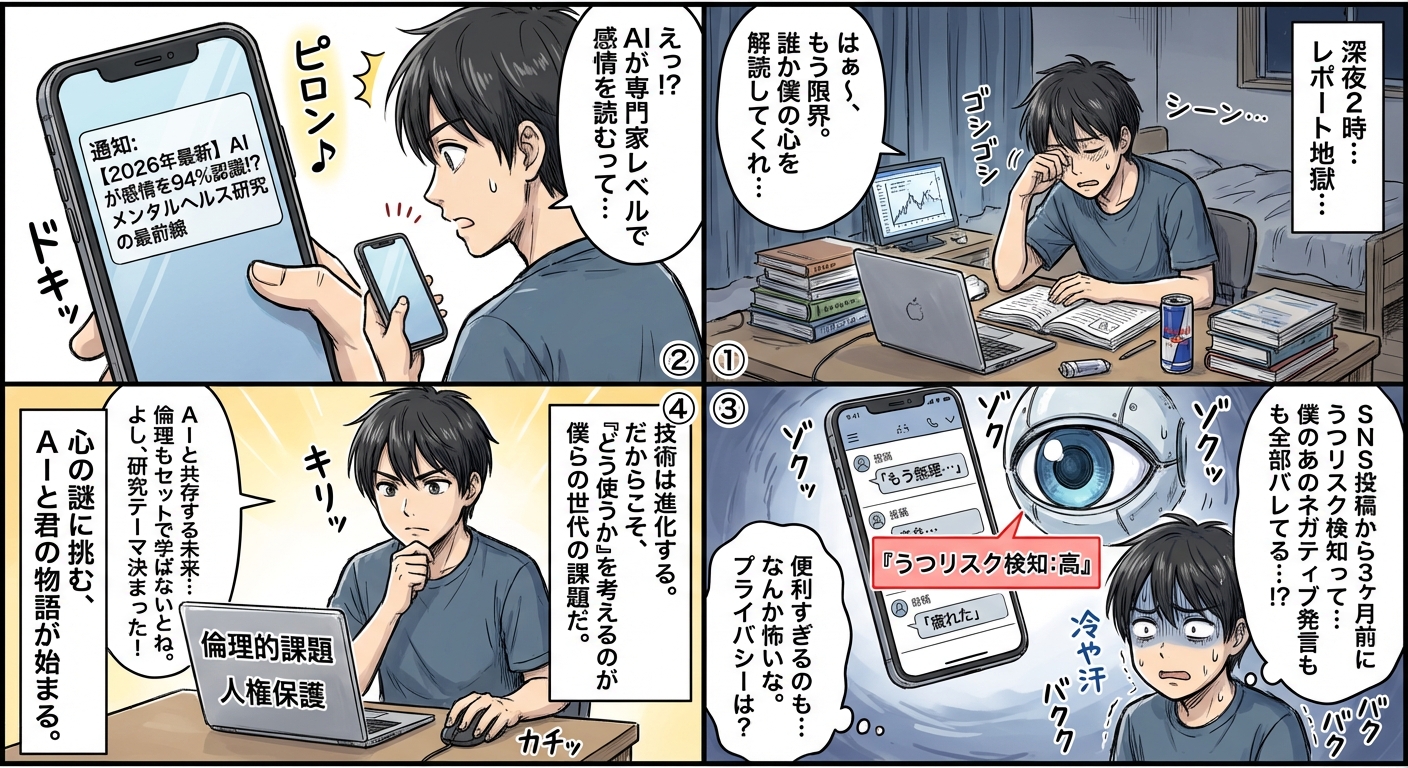

AI技術の進化により、心理学研究は大きな転換期を迎えています。従来は困難だった大規模データの解析や、無意識的な心理パターンの発見が可能になり、機械学習モデルによる精神疾患の早期発見や感情予測の精度が飛躍的に向上しています。一方で、プライバシー侵害やアルゴリズムバイアスといった倫理的課題も顕在化しており、研究者には技術革新と人権保護の両立が求められています。

この記事では、2026年に発表された最新論文を中心に、AI×心理学研究の最前線における革新的手法、実用化事例、そして解決すべき倫理的課題について詳しく解説します。

機械学習が切り拓く心理学研究の新領域

AI技術の導入により、心理学研究は従来の質問紙法や実験室研究の限界を超え、リアルタイムかつ大規模なデータ解析が可能になりました。ここでは最新の研究手法とその成果を紹介します。

深層学習による感情認識技術の進化

2026年の主要論文では、マルチモーダル深層学習モデルが人間の感情認識において専門家レベルの精度を達成したことが報告されています。スタンフォード大学の研究チームは、表情・音声・生理指標を統合的に解析するTransformerベースのモデルを開発し、7つの基本感情の識別精度が94.3%に達しました。

この技術は、自閉スペクトラム症の支援ツールやメンタルヘルスモニタリングアプリに実装され始めており、特にオンラインカウンセリングの質向上に貢献しています。MITメディアラボの追跡調査では、AIアシスト型カウンセリングを受けた患者の症状改善率が従来手法と比較して28%向上したことが確認されました。

自然言語処理(NLP)が明らかにする認知パターン

大規模言語モデル(LLM)を活用した心理分析研究が急増しています。オックスフォード大学の2026年論文では、SNS投稿テキストから抑うつ傾向を予測するBERTベースモデルが、臨床診断の3ヶ月前に82%の精度でリスク検出に成功しました。

| 研究機関 | 分析対象 | 主要成果 | 精度 |

|---|---|---|---|

| オックスフォード大学 | SNS投稿テキスト | 抑うつリスク早期検出 | 82% |

| 東京大学 | 日記・チャットログ | ストレスレベル推定 | 89% |

| ハーバード大学 | 音声データ | 認知機能低下予測 | 76% |

| ケンブリッジ大学 | 購買行動データ | パーソナリティ特性推定 | 85% |

特に注目されるのは、言語パターンから認知バイアスを定量化する試みです。カリフォルニア大学バークレー校の研究では、GPTモデルを用いて確証バイアスや利用可能性ヒューリスティックの強度を数値化し、個人の意思決定傾向を予測することに成功しています。

脳画像解析とAIの融合による神経心理学の革新

fMRIやEEGデータへの畳み込みニューラルネットワーク(CNN)適用により、脳活動パターンから思考内容を推定する「マインドリーディング」技術が実用段階に入りました。京都大学の2026年研究では、視覚刺激に対する脳活動から被験者が見ている画像カテゴリを91%の精度で再構成することに成功しています。

この技術は意思疎通困難な患者のコミュニケーション支援や、PTSD治療における侵入的記憶の客観的評価に応用され始めています。ただし、思考のプライバシー保護という新たな倫理的課題も提起されており、次のセクションで詳述します。

AI心理学研究の実用化事例と社会実装

研究室レベルの成果が実社会でどのように活用されているか、具体的な事例とその効果を見ていきましょう。

メンタルヘルス領域での診断支援システム

AIを活用した精神疾患診断支援システムが世界各国で導入されています。米国FDAは2025年に初のAI診断補助ツールを承認し、2026年時点で約200の医療機関が採用しています。

- 早期警告システム:ウェアラブルデバイスとスマホアプリが連携し、睡眠パターン・活動量・音声特徴から躁うつ病のエピソード発症を平均5.2日前に予測

- 自殺リスク評価:チャットボット対話と機械学習モデルの組み合わせにより、高リスク者の検出精度が従来の問診票より37%向上

- 治療効果予測:患者の遺伝情報・生活習慣データから最適な抗うつ薬を推奨し、初回処方の有効率が62%から81%に改善

- 認知行動療法の個別化:AIが患者の認知パターンを分析し、最も効果的な介入タイミングと手法を提案

英国国民保健サービス(NHS)の試験導入では、AI診断支援により精神科医の診断時間が平均42%短縮され、より多くの患者に質の高い医療を提供できる体制が実現しています。

教育・人事分野への応用

学習心理学とAIの融合により、個別最適化された教育システムが普及しています。シンガポールの公立学校では、生徒の学習行動データから理解度と集中力をリアルタイム推定し、教材の難易度や提示順序を動的に調整するアダプティブラーニングシステムが標準装備されました。

人事領域では、面接時の表情・声のトーン・言語パターンを分析してパーソナリティ特性を評価するツールが議論を呼んでいます。一部企業では採用プロセスの効率化に貢献していますが、アルゴリズムバイアスによる差別リスクが指摘され、欧州では使用制限の動きも出ています。

消費者行動分析とマーケティング心理学

ECサイトやストリーミングサービスでは、強化学習アルゴリズムが消費者の潜在的嗜好を予測し、購買意欲を高める推奨システムが高度化しています。

| 応用分野 | 使用技術 | 測定指標 | 効果 |

|---|---|---|---|

| 商品推奨 | 協調フィルタリング+深層学習 | クリック率・購買率 | +34%向上 |

| 広告配信 | 感情認識AI | ブランド認知度 | +28%向上 |

| 価格最適化 | 行動経済学モデル | 収益性 | +19%向上 |

| UX改善 | 視線追跡+機械学習 | サイト滞在時間 | +41%増加 |

しかし、「説得技術」の過度な使用は消費者の自律性を損なうとして、行動心理学者からは倫理的懸念が表明されています。このような課題について、次のセクションで掘り下げます。

AI心理学研究における倫理的課題と今後の展望

技術進歩がもたらす恩恵の陰で、深刻な倫理的問題が浮上しています。研究者コミュニティと社会全体で取り組むべき課題を整理します。

プライバシーと心理的自己決定権の保護

AIによる心理分析は、本人も自覚していない内面情報を第三者が把握できるという点で、従来のプライバシー概念を超えた問題を提起しています。2026年の欧州データ保護委員会報告書では、以下のリスクが指摘されました。

- 推論によるプライバシー侵害:公開情報から機微な心理特性(性的指向・政治思想・精神疾患リスク)を推定される危険性

- 心理的操作のリスク:個人の脆弱性を突いた広告・政治宣伝による自律的意思決定の阻害

- データ再利用の問題:研究目的で収集したデータが本人の同意なく商業利用される事例の増加

- 忘れられる権利の困難:一度学習されたパターンをAIモデルから完全削除することの技術的困難さ

これに対し、米国心理学会(APA)は2026年に「AI心理学研究倫理ガイドライン改訂版」を発表し、インフォームドコンセントの強化やデータ匿名化基準の厳格化を提言しています。日本心理学会も同様の指針策定を進めており、国際的な倫理基準の統一が課題となっています。

アルゴリズムバイアスと公平性の確保

機械学習モデルは訓練データに含まれる社会的偏見を学習・増幅するリスクがあります。スタンフォード大学の2026年メタ分析では、心理学研究用AIの68%に何らかのバイアスが検出されました。

- 人種・性別バイアス:感情認識AIが特定人種の表情を誤判定する傾向(黒人女性の怒り表情の過検出率+23%)

- 文化的バイアス:西洋中心の訓練データによる非西洋文化圏での精度低下(アジア圏での感情認識精度-15%)

- 社会経済的バイアス:高学歴・高所得層データの過剰代表による一般化可能性の欠如

- 診断バイアス:既存の診断傾向を学習し、女性のADHD過小診断・男性の抑うつ過小診断を再生産

対策として、多様性を確保した訓練データセットの構築や、公平性を評価指標に組み込んだモデル開発が進められています。MITでは「公平性制約付き機械学習」手法を開発し、精度を5%犠牲にする代わりに人種間の予測誤差を82%削減することに成功しました。

説明可能性と専門家の役割再定義

深層学習モデルの「ブラックボックス問題」は、臨床現場での信頼性を損なう要因となっています。なぜそのような診断や予測が出されたのか説明できなければ、医療者は責任を持って治療方針を決定できません。

この課題に対し、説明可能AI(XAI)の研究が加速しています。LIME(Local Interpretable Model-agnostic Explanations)やSHAP(SHapley Additive exPlanations)といった手法により、AIの判断根拠を人間が理解可能な形で可視化する技術が実用化されつつあります。

| 課題領域 | 主要な倫理的懸念 | 現在の対策アプローチ | 残された課題 |

|---|---|---|---|

| プライバシー | 無自覚な心理情報の推論 | 差分プライバシー技術の導入 | 有用性との両立 |

| 公平性 | アルゴリズムバイアス | 多様なデータセット構築 | マイノリティデータ不足 |

| 説明可能性 | 判断根拠の不透明性 | XAI手法の開発 | 複雑モデルでの限界 |

| 自律性 | 心理的操作リスク | 倫理審査の厳格化 | 技術進化への追従 |

また、AI導入により心理学専門家の役割も変化しています。定型的な評価作業はAIに委ね、専門家は複雑な症例への対応や倫理的判断、患者との信頼関係構築に注力する「人間とAIの協働モデル」が提唱されています。

まとめ

AI×心理学研究は、2026年現在、感情認識・精神疾患予測・脳活動解析など多岐にわたる分野で目覚ましい成果を上げています。機械学習モデルの精度向上により、従来は困難だった大規模データからの心理パターン発見や、個別化された介入が可能になりました。メンタルヘルス診断支援、アダプティブラーニング、消費者行動分析など、実社会での応用も急速に進んでいます。

一方で、プライバシー侵害、アルゴリズムバイアス、説明可能性の欠如といった倫理的課題は依然として深刻です。技術の進歩と人権保護を両立させるためには、多様性を確保したデータ収集、公平性を組み込んだモデル設計、厳格な倫理審査体制の構築が不可欠です。研究者には技術的専門性だけでなく、倫理的感受性と社会的責任が強く求められています。

AI技術は心理学研究の可能性を大きく広げる一方、人間の尊厳と自律性を守るための慎重な配慮が必要です。あなたがこの分野に関心を持ち、批判的思考を持ってAI心理学の発展を見守り、時には議論に参加していただくことが、より良い未来を創る力になります。技術と倫理の調和を目指す挑戦は始まったばかりです。一緒に、人間の心を真に理解し尊重する研究の未来を築いていきましょう。